Dans un contexte où l'intelligence artificielle révolutionne nos méthodes de travail, la mise en place d'outils IA internes devient un enjeu stratégique pour les entreprises. Chez Scaleway, notre équipe AI Tooling a relevé ce défi en déployant un chatbot interne en moins de trois mois. Retour sur cette expérience et les enseignements clés pour ceux qui souhaitent se lancer dans une démarche similaire.

Une approche méthodique : comprendre avant d'agir

La première étape cruciale de notre démarche a été de cartographier précisément les besoins internes. À travers une série d'échanges avec les différentes équipes de Scaleway, nous avons pu identifier les points de friction quotidiens et les opportunités d'amélioration. Cette phase d'analyse nous a permis de construire une vision claire des usages existants et de la valeur ajoutée potentielle de notre solution.

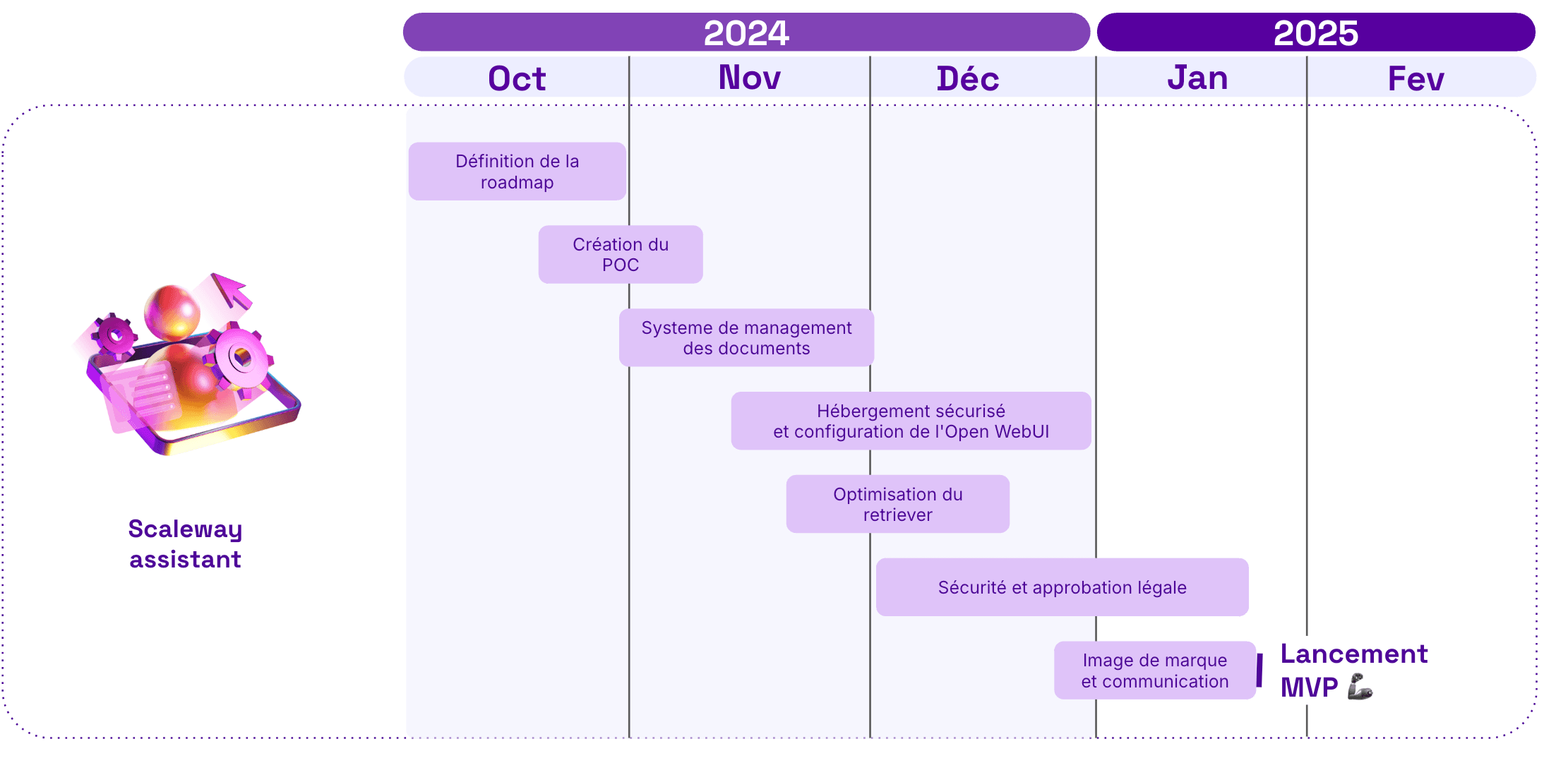

Cette compréhension approfondie nous a conduits à établir une roadmap structurée des projets d'IA internes. Chaque initiative a été évaluée selon deux critères principaux : son impact (nombre de collaborateurs concernés et heures gagnées par semaine) et son coût (infrastructure sur cinq ans et développement, incluant maintenance).

Cette évaluation approfondie nous a permis de calculer un retour sur investissement prometteur, basé sur le temps gagné par les employés et la réduction de la charge de l'équipe RH. Ces calculs ont confirmé la pertinence du projet et justifié son lancement rapide.

Face à l'utilisation croissante de chatbots externes par nos équipes, le choix s'est naturellement porté sur le développement d'un chatbot interne. Cette solution répond à un double objectif : capitaliser sur les habitudes de travail existantes tout en garantissant la sécurité de nos données sensibles.

On a donc défini une roadmap jusqu'à fin janvier avec les éléments à mettre en place pour rendre ce chatbot disponible.

Définition du périmètre du MVP

Pour garantir une mise en production rapide et efficace, nous avons opté pour trois modèles distincts avec des usages différents :

- Un modèle généraliste pour les conversations courantes

- Un modèle spécialisé dans les données RH internes, utilisant le RAG pour répondre aux questions sur les congés, l'utilisation des locaux et la gestion des contrats

- Un modèle dédié au code pour l'assistance technique

Le tout dans une interface user friendly, semblable à ChatGPT, pour assurer une utilisation facile pour chaque employé (avec un niveau plus ou moins technique).

La simplicité était au cœur de notre approche, privilégiant l'utilisation d'outils existants avec des adaptations minimales. Ce choix stratégique visait à obtenir rapidement des retours utilisateurs pour itérer sur le projet.

Notre focus initial s'est porté sur les données RH, un choix motivé par plusieurs facteurs :

- Une documentation bien structurée dans Confluence

- Une portée touchant l'ensemble des employés

- Un besoin récurrent d'assistance de l'équipe RH

- Une opportunité de simplifier la recherche d'information, souvent fastidieuse dans Confluence

La protection de la vie privée était une priorité absolue dès la conception du MVP.

Toutes les conversations sont chiffrées de bout en bout et inaccessibles à notre équipe, garantissant ainsi une confidentialité totale des échanges entre les utilisateurs et le chatbot.

Accélérer la mise en production

Notre choix de capitaliser sur l'écosystème open source s'est révélé déterminant. L'utilisation d'outils comme Open WebUI, LlamaIndex et du modèle LLaMA 3.1 70B nous a permis d'avancer rapidement tout en gardant la maîtrise de notre solution. Cette approche s'inscrit parfaitement dans l'ADN de Scaleway, qui promeut l'innovation ouverte et accessible.

La synergie avec les produits Scaleway existants a également joué un rôle crucial. L'utilisation de nos bases de données internes, de nos Generative APIs pour les LLM et embeddings, ainsi que de notre infrastructure à la demande, a grandement facilité le développement et le déploiement de la solution.

Excellence opérationnelle

L'essentiel de notre effort de développement s'est concentré sur deux aspects critiques : l'implémentation du système RAG et la mise en production. Cette focalisation s'est accompagnée d'objectifs précis en termes de performance et de sécurité. Le monitoring constant de la qualité des réponses, à travers des tests complets tant sur le retrieval que sur les performances end-to-end, nous a permis d'optimiser continuellement notre solution. La sécurité n'a pas été négligée, avec la mise en place d'une base de données chiffrée et d'un déploiement exclusif sur notre réseau privé.

Pour mesurer l'impact et l'adoption de notre solution, nous avons mis en place un système de monitoring respectueux de la vie privée. Ce système nous permet de suivre des métriques clés comme le nombre de requêtes par utilisateur, les temps de réponse et les taux de satisfaction, sans compromettre la confidentialité des échanges. Ces données sont précieuses pour identifier les cas d'usage les plus pertinents et guider nos développements futurs. Par exemple, nous avons constaté une forte utilisation pendant les périodes de recrutement et d'onboarding, ce qui nous a conduits à prioriser l'enrichissement des contenus liés à ces processus.

Une réussite collective tournée vers l'avenir

Cette expérience démontre qu'avec une approche structurée et des choix technologiques pertinents, il est possible de déployer rapidement des solutions d'IA internes efficaces. La clé réside dans l'équilibre entre ambition et pragmatisme, entre innovation et sécurité.

Chez Scaleway, nous sommes convaincus que l'avenir de l'IA en entreprise passe par des solutions agiles, ouvertes et souveraines. Ce projet n'est qu'une première étape dans notre démarche de démocratisation de l'IA au service de la performance collective.

Analyse de l'adoption

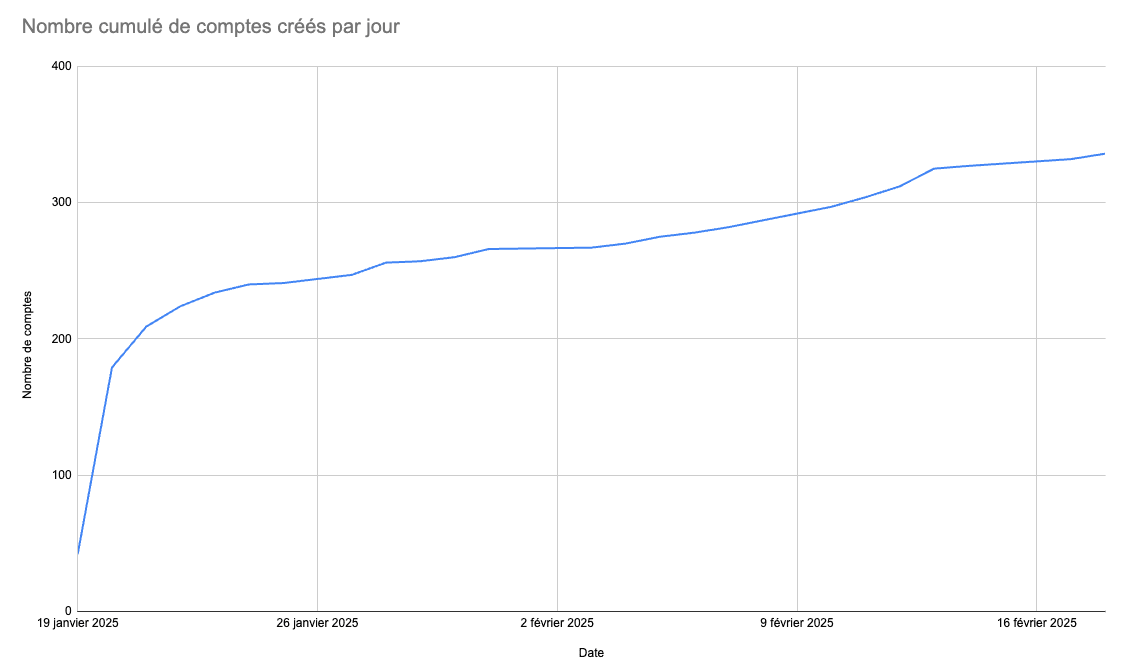

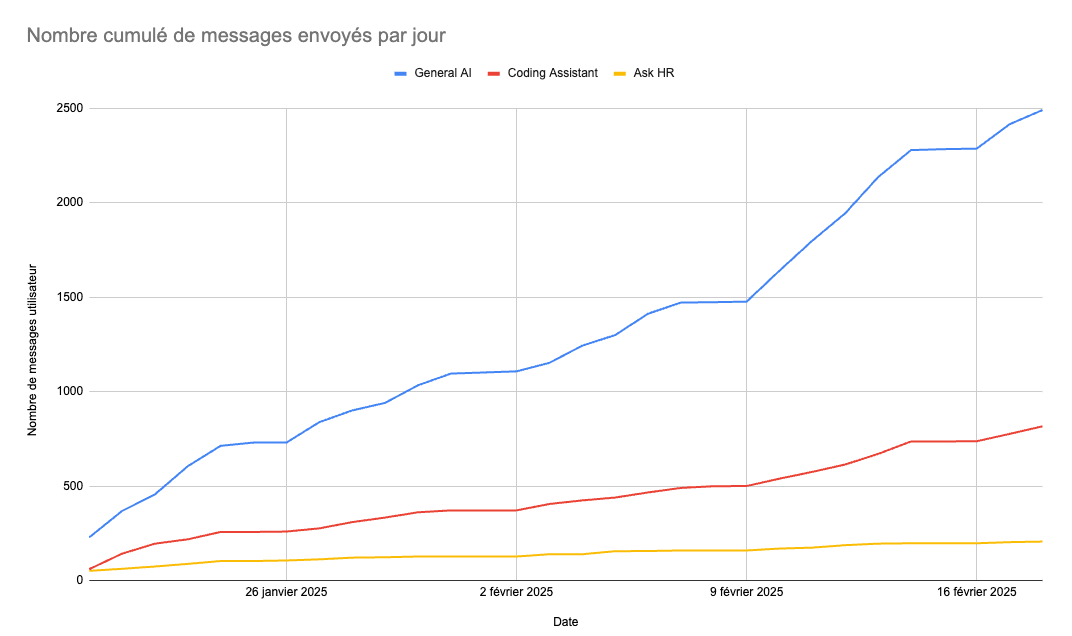

Les données d'utilisation confirment le succès du lancement de la solution d'IA interne. En seulement deux jours, plus de 200 utilisateurs ont testé la plateforme, traduisant un fort intérêt initial. Cette adoption rapide illustre la pertinence du besoin auquel répond cet outil et la curiosité des équipes pour ces nouvelles capacités.

Au-delà de l'engouement initial, l'analyse du volume de messages envoyés met en lumière une adoption réelle et croissante. En moins d'un mois, plus de 3 500 messages ont été échangés via la plateforme, témoignant d'un usage récurrent. Le second graphique révèle un rythme soutenu de sollicitations en semaine, avec des plateaux réguliers observés durant les week-ends. Ce phénomène confirme une intégration progressive de l'outil dans le quotidien des équipes.

Enfin, la tendance observée sur les deux dernières semaines montre une augmentation continue du nombre de messages par jour. Cet indicateur clé souligne que l'adoption ne se limite pas à un effet de nouveauté, mais traduit un enracinement durable de la solution dans les pratiques de travail chez Scaleway.

La prochaine phase du projet prévoit l'extension des sources de données à d'autres espaces Confluence et à la documentation publique. Nous planifions également l'intégration du chatbot à Slack pour multiplier les points d'accès et faciliter son utilisation au quotidien.

Enseignements clés

Notre expérience a mis en lumière plusieurs défis significatifs. Sur le plan de l'infrastructure et de la sécurité, la mise en place sur des serveurs sécurisés pour les données sensibles a nécessité une attention particulière, tout comme la vérification rigoureuse de la sécurité des données utilisateurs qui s'est révélée cruciale. En ce qui concerne l'optimisation du RAG, nous avons constaté que l'adaptation du système doit être finement ajustée selon la typologie des textes. De plus, de nombreux tests se sont avérés nécessaires pour atteindre un niveau de performance satisfaisant. Enfin, le monitoring continu s'est imposé comme un élément essentiel permettant d'identifier les axes d'amélioration.